Apache Eagle, pôvodne vyvinutý na eBay, potom venovaný nadácii Apache Software Foundation, vypĺňa veľkú medzeru v zabezpečení údajov, ktorá zostáva riedko osídlená, ak nie úplne prázdna: Vyňuchá možné problémy s bezpečnosťou a výkonom pomocou rámcov veľkých dát.

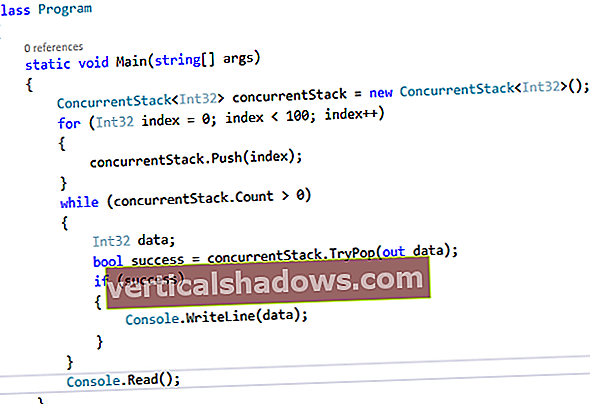

Na to používa Eagle ďalšie komponenty open source Apache, ako sú Kafka, Spark a Storm, na generovanie a analýzu modelov strojového učenia z údajov o chovaní klastrov veľkých údajov.

Pohľad zvnútra

Údaje pre Eagle môžu pochádzať z protokolov aktivít pre rôzne zdroje údajov (HDFS, Hive, MapR FS, Cassandra) alebo z metrík výkonu získaných priamo z rámcov ako Spark. Údaje potom môže streamovací rámec Kafka pipetovať do detekčného systému v reálnom čase, ktorý je zabudovaný do Apache Storm, alebo do modelového tréningového systému postaveného na Apache Spark. Prvé z nich slúžia na generovanie varovaní a správ na základe existujúcich zásad; posledná uvedená je na vytváranie modelov strojového učenia s cieľom zaviesť nové politiky.

Tento dôraz na správanie v reálnom čase je na vrchole zoznamu „kľúčových vlastností“ v dokumentácii pre Eagle. Nasleduje „škálovateľnosť“, „riadené metadátami“ (čo znamená, že zmeny v politikách sa implementujú automaticky pri zmene ich metadát) a „rozšíriteľnosť“. To posledné znamená, že zdroje údajov, systémy varovania a nástroje na správu politík používané programom Eagle sú dodávané doplnkami a neobmedzujú sa iba na to, čo je v balení.

Pretože Eagle bol zostavený z existujúcich častí sveta Hadoop, má dve teoretické výhody. Jeden, je tu menšia potreba opätovného objavenia sa kolesa. Dvaja, tí, ktorí už majú s predmetnými kúskami skúsenosti, budú mať nohu hore.

Čo chystajú moji ľudia?

Okrem vyššie spomenutých prípadov použitia, ako je analýza výkonu úloh a monitorovanie anomálneho správania, môže program Eagle analyzovať aj správanie používateľov. Nejde o, povedzme, analýzu dát z webovej aplikácie, aby sme sa dozvedeli o verejných používateľoch aplikácie, ale skôr o samotných používateľoch rámca veľkých dát - o budovaní a správe koncových zariadení Hadoop alebo Spark. Zahrnutý je príklad toho, ako spustiť takúto analýzu, ktorá môže byť nasadená tak, ako je, alebo upravená.

Eagle tiež umožňuje klasifikovať prístup k dátam aplikácií podľa úrovne citlivosti. Túto funkciu môžu v súčasnosti využívať iba aplikácie HDFS, Hive a HBase, ale jej interakcia s nimi poskytuje model pre klasifikáciu ďalších zdrojov údajov.

Držme to pod kontrolou

Pretože rámce veľkých dát sú rýchlo sa rozvíjajúce výtvory, bolo ťažké okolo nich vybudovať spoľahlivé zabezpečenie. Predpokladom spoločnosti Eagle je, že môže poskytnúť politickú analýzu a varovanie ako možný doplnok k iným projektom, ako je Apache Ranger. Ranger poskytuje autentifikáciu a riadenie prístupu v rámci Hadoop a súvisiacich technológií; Eagle vám dá určitú predstavu o tom, čo ľudia robia, keď ich pustia dovnútra.

Najdôležitejšou otázkou, ktorá sa vznáša nad budúcnosťou Eagle - áno, už teraz - je, do akej miery ju predajcovia Hadoop elegantne zavedú do svojich existujúcich distribúcií alebo využijú svoje vlastné ponuky zabezpečenia. Bezpečnosť a správa údajov sú už dlho jedným z chýbajúcich prvkov, o ktoré by mohli konkurovať obchodné ponuky.